Současná (asi) revoluce kolem umělé inteligence je poháněná velkými datovými centry, která jsou plná AI čipů, většinou GPU. Mluví se hlavně o Nvidii, jenž se díky svému silnému postavení stala nejhodnotnější firmou planety. Ovšem není to jen o ní. Velké plány má AMD, jejíž budoucí line-up vypadá slušně. Na síle nabírají čipy ASIC vytvořené pro specifické úlohy kolem AI. Velké instalace ve svých cloudech mají i Amazon Web Services (Inferentia a Trainium) a Google (TPU, na nichž byly natrénovány modely Gemini 3). A pak je zde velmi specifická značka Cerebras Systems dodávající největší čipy na světě.

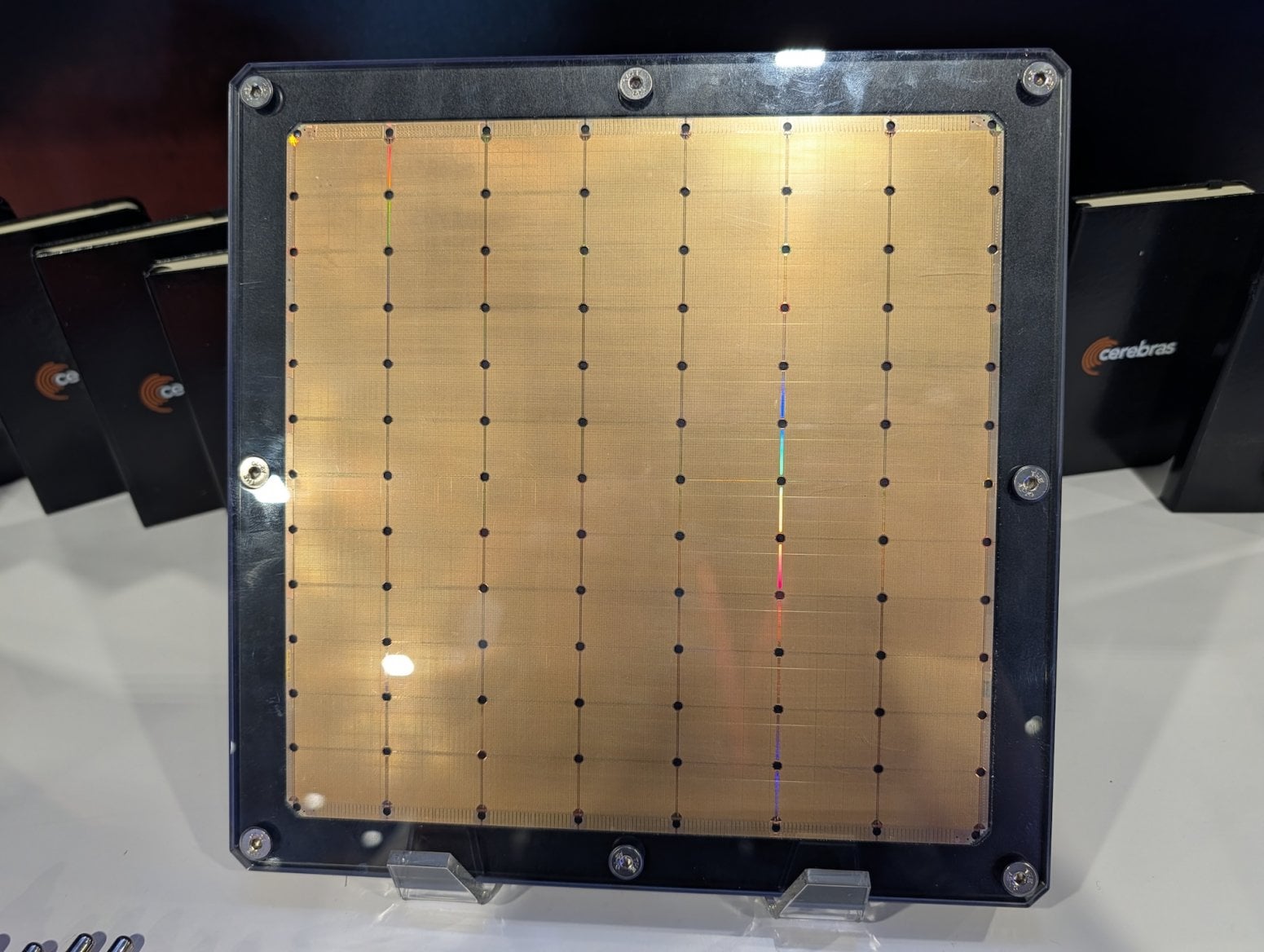

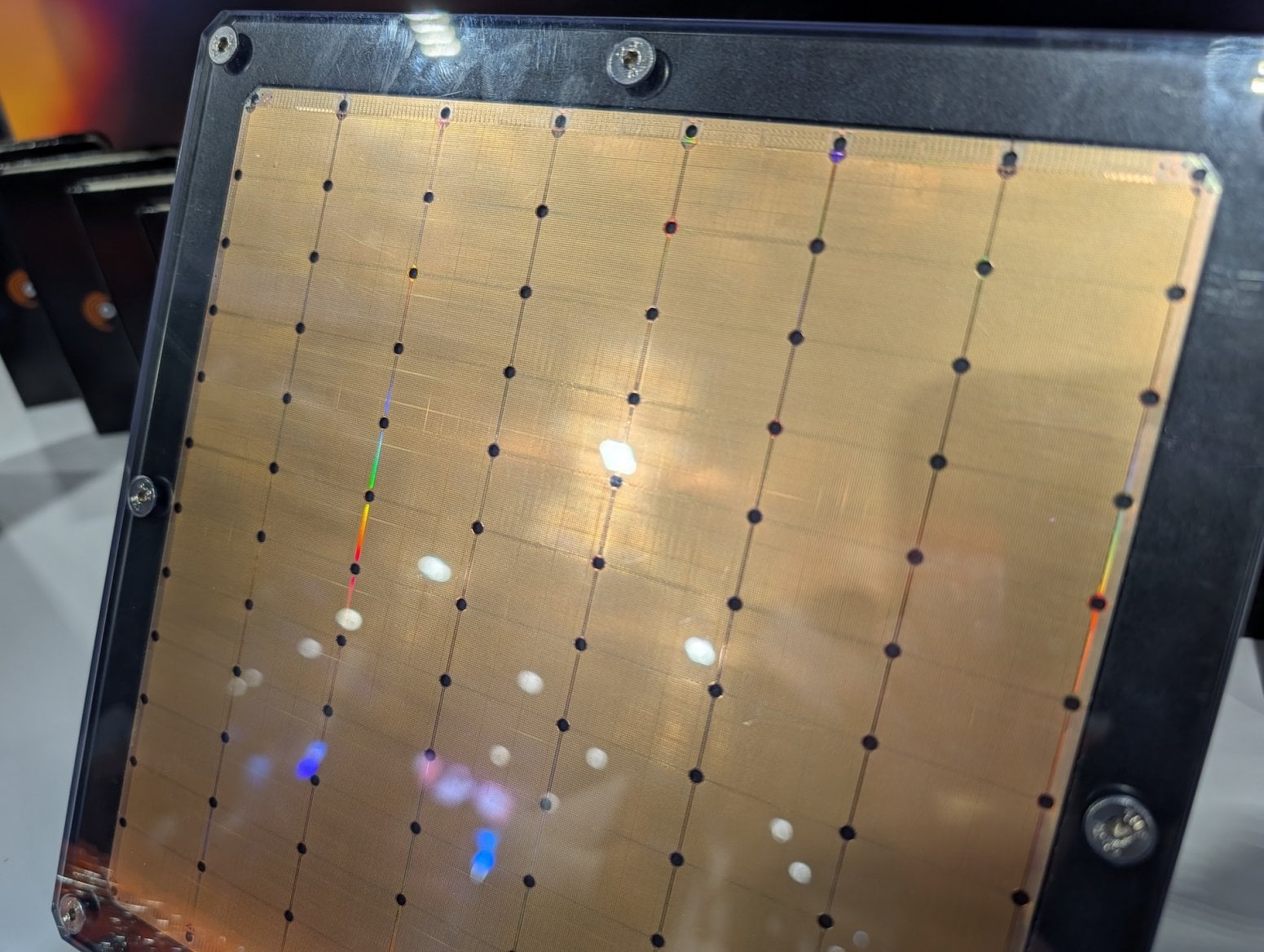

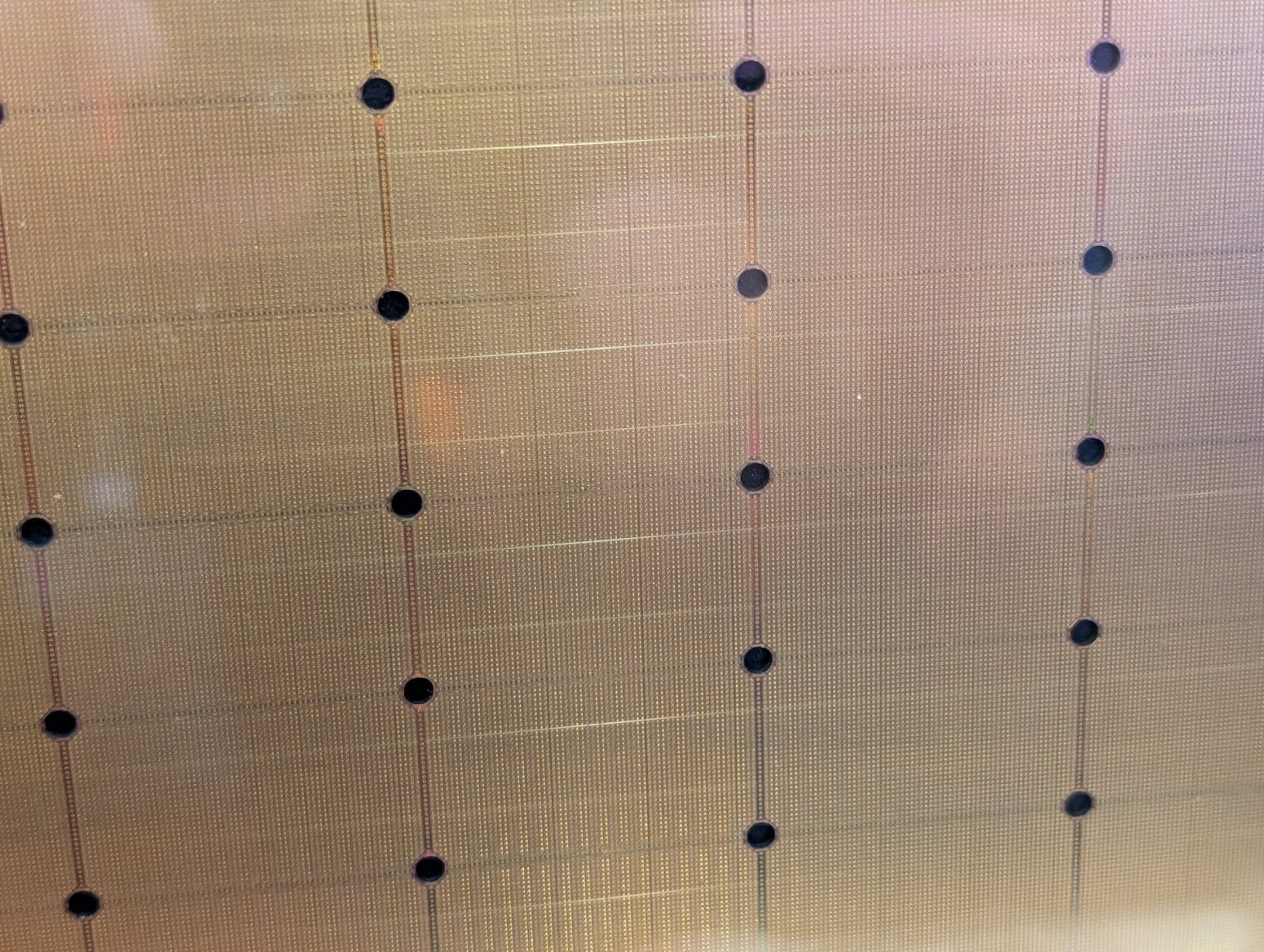

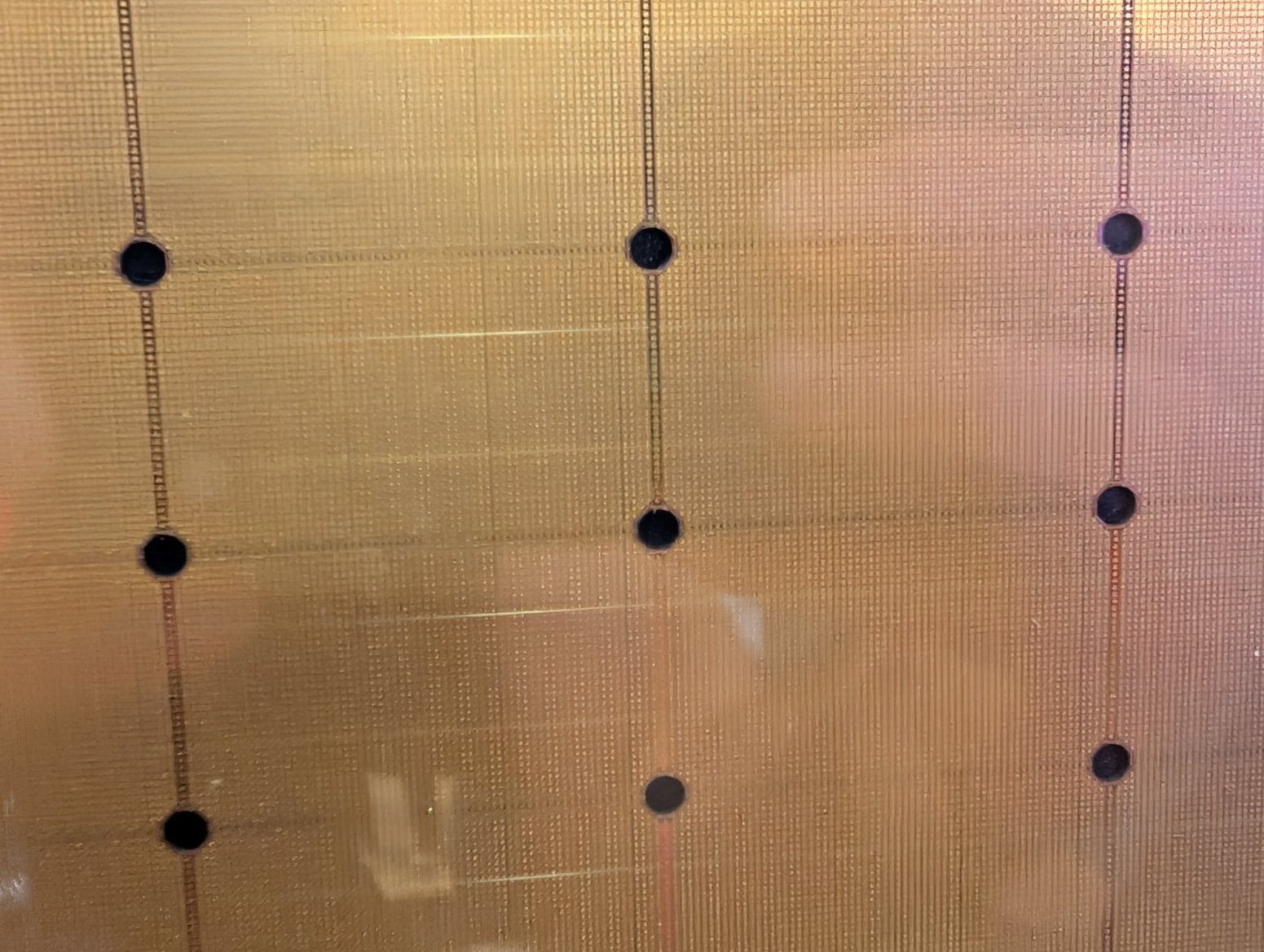

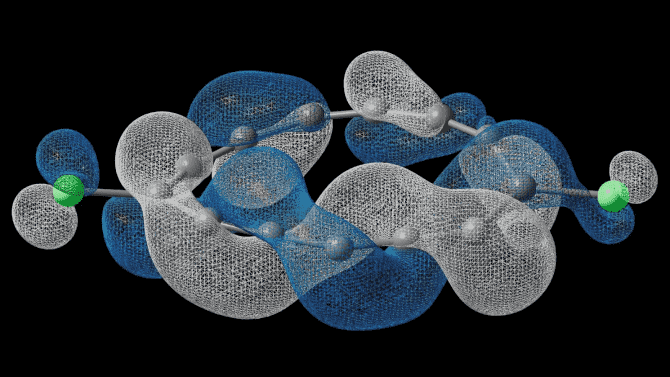

Cerebras vznikl v roce 2016 v Kalifornii a na trh už dodal třetí generaci svého čipu s názvem Wafer-Scale Engine neboli WSE. Firma do praxe uvádí myšlenku, která se v minulosti zdála technicky hodně komplikovaná. WSE je čip zabírající v podstatě celý wafer. Wafery jsou polovodičové desky, do nichž se v továrnách “vypalují” samotné čipy (integrované obvody). Na takový wafer se typicky vejde hromada čipů s tím, že se deska rozřeže na jednotlivé kusy. Cerebras nic řezat nemusí, respektive čip ořízne do hranatého tvaru (wafery jsou typicky kulaté).

Cerebras na svůj nápad dostala celkové investice ve výši 1,8 miliardy dolarů, což jí ohodnotilo na více než osm miliard dolarů. Poslední investiční kolo se odehrálo letos v září, kdy přiteklo 1,1 miliardy dolarů.

Velmi rychlá paměť

Na trhu je nyní čip WSE-3. Modely od Nvidie jsou oproti tomu takoví žebráčci. WSE-3 je například zhruba 57× větší než Nvidia H100. Plocha čipu je 46 225 milimetrů čtverečních a celkově se na ní vejdou čtyři biliony tranzistorů (druhá verze měla 2,6 bilionu tranzistorů). Nvidia B300 má 208 miliard tranzistorů. Na Cerebras WSE-3 je možné se podívat v naší galerii pořízené na konferenci AWS re:Invent 2025 v Las Vegas (AWS je partnerem Cerebrasu).

Počet AI jader dosahuje na 900 tisíc. Celkový AI výkon by měl dělat 125 petaflops (FP16), což je mnohonásobek výkonu Nvidia B200. WSE-3 lze navíc sdružovat do clusterů, celkově jich lze spojit až 2 048 a dosáhnout výkonu 256 exaflops.

Samotný čip se umisťuje do systémů Cerebras CS-3, které obsahují chlazení a další komponenty. Spotřeba takové instalace činí 23 kW při velikosti 15U rack.

Součástí čipu je 44 GB paměti SRAM s velmi vysokou propustností 21 PB/s a propustností mezi jádry 214 Pb/s. To jsou velmi významné parametry, které odstraňují tradiční úzká hrdla menších čipů spojená s rychlostí a objemem předávaných dat. Pokud by integrovaná paměť nestačila, je možné nasadit rozšíření MemoryX, které lze dostat až na 1,2 PB.

Čip je navržen pro trénovaní modelů s biliony parametrů. Model se často vejde do jednoho logického paměťového prostoru, což má vliv na rychlost trénování a zjednodušení celého procesu. Možné je používat také inferenci, čip u některých AI modelů zvládne generovat až dva tisíce tokenů za sekundu.

Nevýhodou Cerebrasu je specializace na AI či vědecké výpočty, čip není univerzální a nelze ho použít třeba na klasické HPC výpočty a podobně. Výroba (aktuálně 5nm proces u TSMC) je stále velmi náročná a je problém s yieldem, tedy “zmetkovostí”, což zvyšuje cenu – jeden čip vyjde na dva až tři miliony dolarů. Spotřeba 23 kW na systém je rovněž výzvou, je potřeba kapalinové chlazení s externím okruhem. Problémem je rovněž slabší softwarový ekosystém a do jisté míry vendor lock-in. Je to tedy něco za něco.

Cerebras své systémy prodává buďto jako samotný hardware, nebo skrze svůj vlastní cloud. Externích partnerů moc není. Cerebras Inference Cloud je dostupný skrze AWS Marketplace, takže je možné technologii pořídit skrze prostředí Amazon Web Services, ale v AWS hardware neběží.

Firma má platící zákazníky jako Mistral, Perplexity, různé vědecké organizace nebo americké ministerstvo energetiky. Uvidíme, zda se koncept podrží dlouhodobě udržet v chodu.