Nástup takzvané umělé inteligence reprezentované velkými jazykovými modely (LLM) udělal z Nvidie nejhodnotnější veřejně obchodovanou firmu planety. Má totiž dominantní postavení v dodávkách grafických čipů, na nichž se v serverech v obřích datacentrech tato AI trénuje a zpracovává. AI akcelerátory ale nejsou pouze doménou Nvidie, na pozadí velice rychle rostou alternativy. Nikdo nechce nadvládu jedné entity. Říkali jste si například, proč akcie Broadcomu za rok vyrostly o skoro 50 procent a za pár posledních let o více než 700 procent? Odpovědí je zkratka ASIC.

ASIC jsou čipy, které nejsou univerzální, ale mají v křemíku “zatavenou” jasně danou funkci, v níž často vynikají a mají dobré provozní hodnoty. ASIC může sloužit k různým účelům a záleží, na co si takový čip navrhnete (třeba pro těžbu krypta). S nástupem AI vznikají modely, které se hodí právě pro zpracování operací týkajících se umělé inteligence.

V podstatě všichni velcí internetoví hráči si navrhují vlastní ASICy pro AI. Dělají na nich Microsoft, Meta, Google nebo Amazon Web Services. Google už má sedmou generaci svých Tensor Processing Unit (TPU), na nichž například natrénoval svůj poslední model Gemini 3. Tedy žádná Nvidia. Big Tech na návrh takovýchto čipů buduje interní týmy inženýrů, zároveň ale spolupracuje s podniky typu Broadcom, Marvell nebo Alchip.

Jak se ukazuje na trénování Gemini 3 na TPU, tyto AI ASICy mohou být velice schopné. Jejich nevýhodou je to, že nejsou vhodné pro širší způsoby použití. Google dosáhl dobrých výsledků díky tomu, že TPU z velké části vystavěl kolem svých technologií (TensorFlow a spol.) a čip optimalizoval. Nvidia či AMD jsou ovšem široce použitelné křemíky (general purpose) a lze s nimi pracovat mnohem pružněji. Když to zjednodušíme, takové TPU je v podstatě připravené pro velmi rychlé násobení matic, zatímco Nvidia a AMD nabízí obecné počítání a paralelní zpracování.

Nvidia po zjištění, že Google v rámci Gemini 3 nepoužil její čipy, samozřejmě reagovala marketingem přesně v duchu své univerzálnosti. To ale nic nemění na tom, že hyperscalers na vlně ASICů dál pojedou a trend bude sílit. Před pár dny to potvrdil největší cloud světa Amazon Web Services, který oznámil nejenom nový AI čip Trainium3, ale také serverový ARM procesor Graviton5 (nedobrá zpráva pro Intel a AMD).

Právě Graviton je pěknou ukázkou, kam se trh dostal. AWS vydal první Graviton v roce 2018. To bylo v době, kdy použití ARMu, architektury známé hlavně z chytrých telefonů, v serverech vypadalo dost bláznivě. “Zákazníci ale Graviton začali nasazovat, protože byl o desítky procent levnější a efektivnější,” popsal Lupě Ali Saidi, viceprezident a Distinguished Engineer v AWS zodpovědný právě za Graviton.

A realita dneška? “Většina výpočetního výkonu, které jsme do AWS v posledních třech letech přidali, jsou Gravitony,” navázal Saidi. Armové procesory používá asi 90 tisíc zákazníků na úlohy všeho druhu. Rozšíření kromě jiného pomohl přechod Applu na čipy M, díky nimž počítače od této firmy rovněž používají ARM a nikoliv x86 jako Intel či AMD. Ekosystém kolem ARMu roste a aplikace se “prostě” kompilují pro jinou architekturu, nejde o nepřekonatelnou překážku.

Saidi dále Lupě potvrdil, že AWS chce nové čipy vydávat každé dva roky, což kromě jiného znamená rychle zvyšovat výkon a efektivitu. Graviton například od třetí verze běží na čipletech a nová verze má mezigenerační růst výkonu o 25 procent. Graviton5 čítá 192 fyzických jader (bez hyper threadingu), L3 cache o velikosti 192 MB, zvládá DDR5–7200, má kolem 132 miliard tranzistorů, frekvenci 3,1 GHz a poprvé podporuje PCIe 6.0. TDP je na 650 wattech. Vyráběn je 3nm procesem TSMC. “V TSMC patříme k největším zákazníkům,” doplnil Saidi.

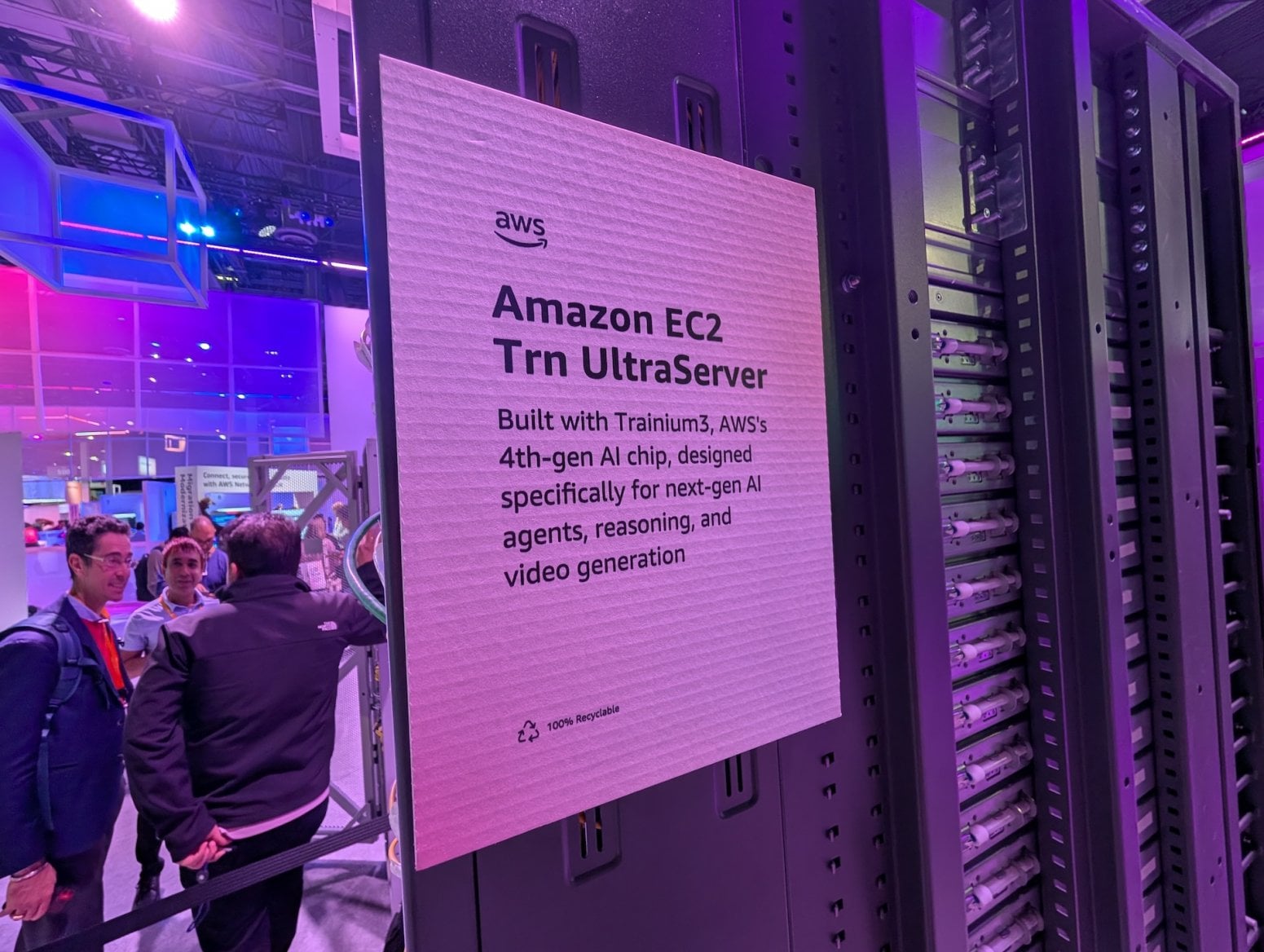

Dále byl oznámen AI čip Trainium3, opět vyrábění pomocí 3nm technologie. Dvojka pro AWS znamenala zlom. Výkonný ředitel Amazonu Andy Jassy uvedl, že AWS už má druhé verze v produkci přes milion kusů a daří se je prodávat i díky funkci Bedrock pro práci s AI. Třetí verze má být až čtyřikrát energeticky efektivnější a nabídnout čtyřnásobný nárůst výkonu.

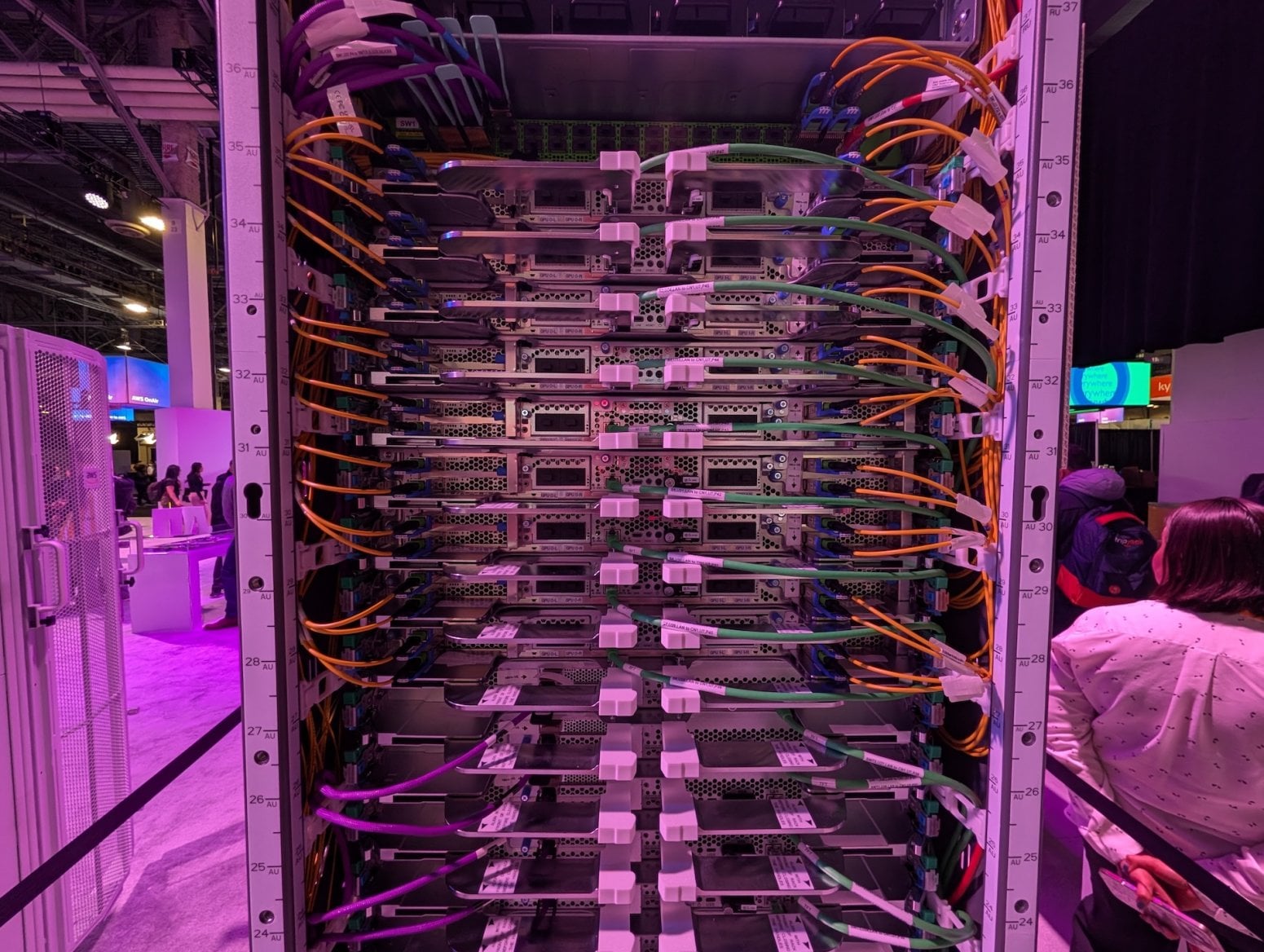

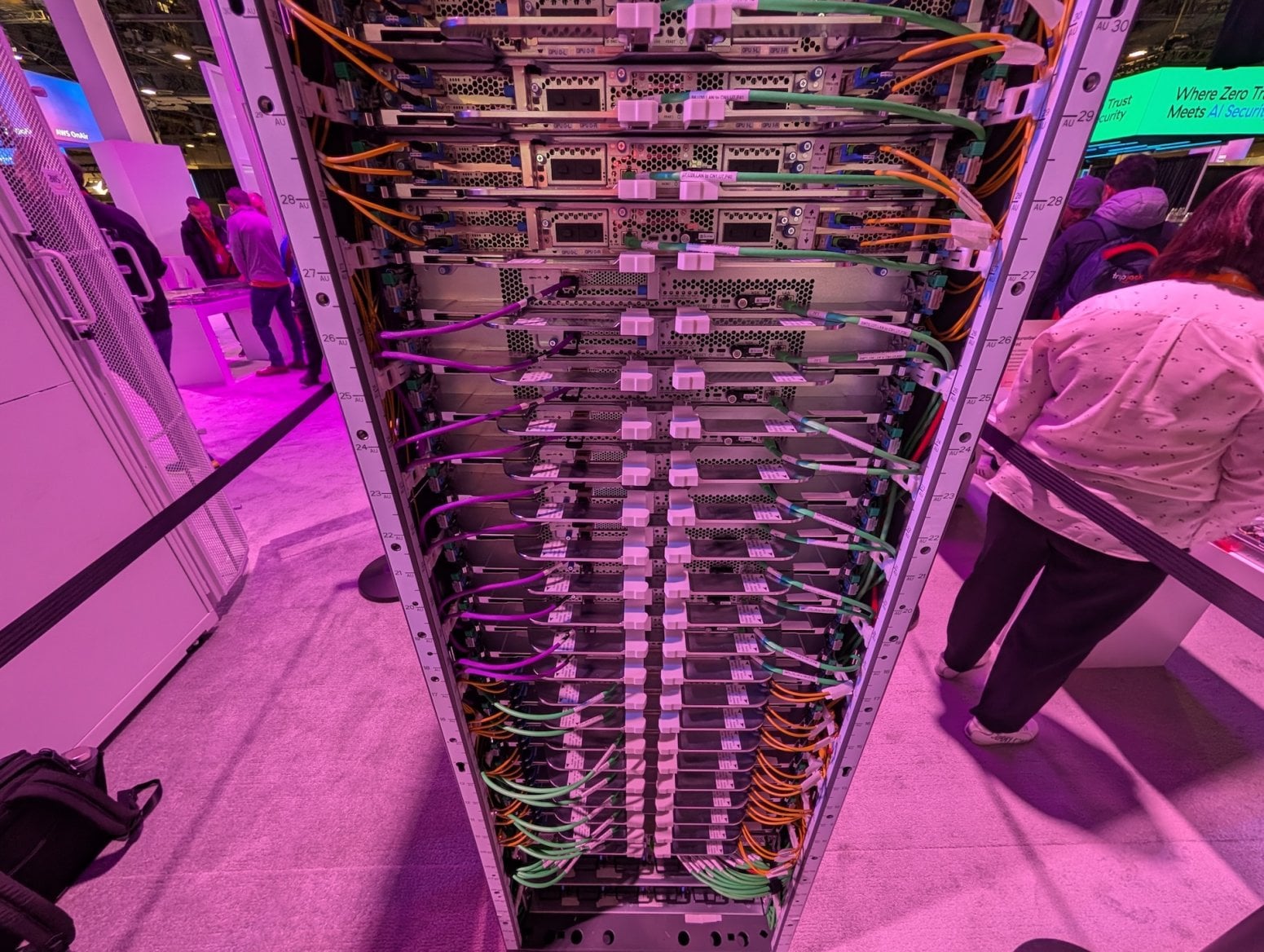

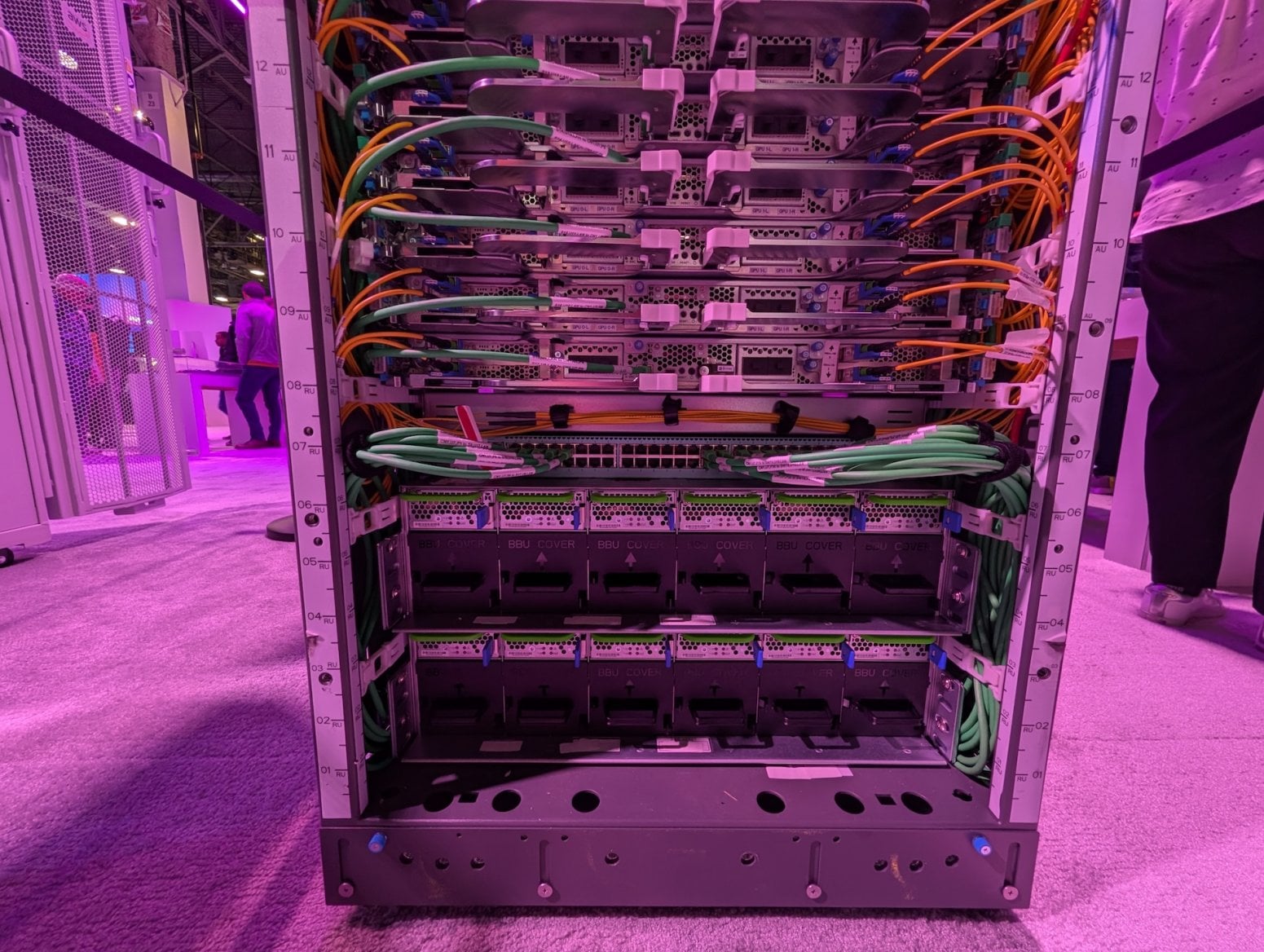

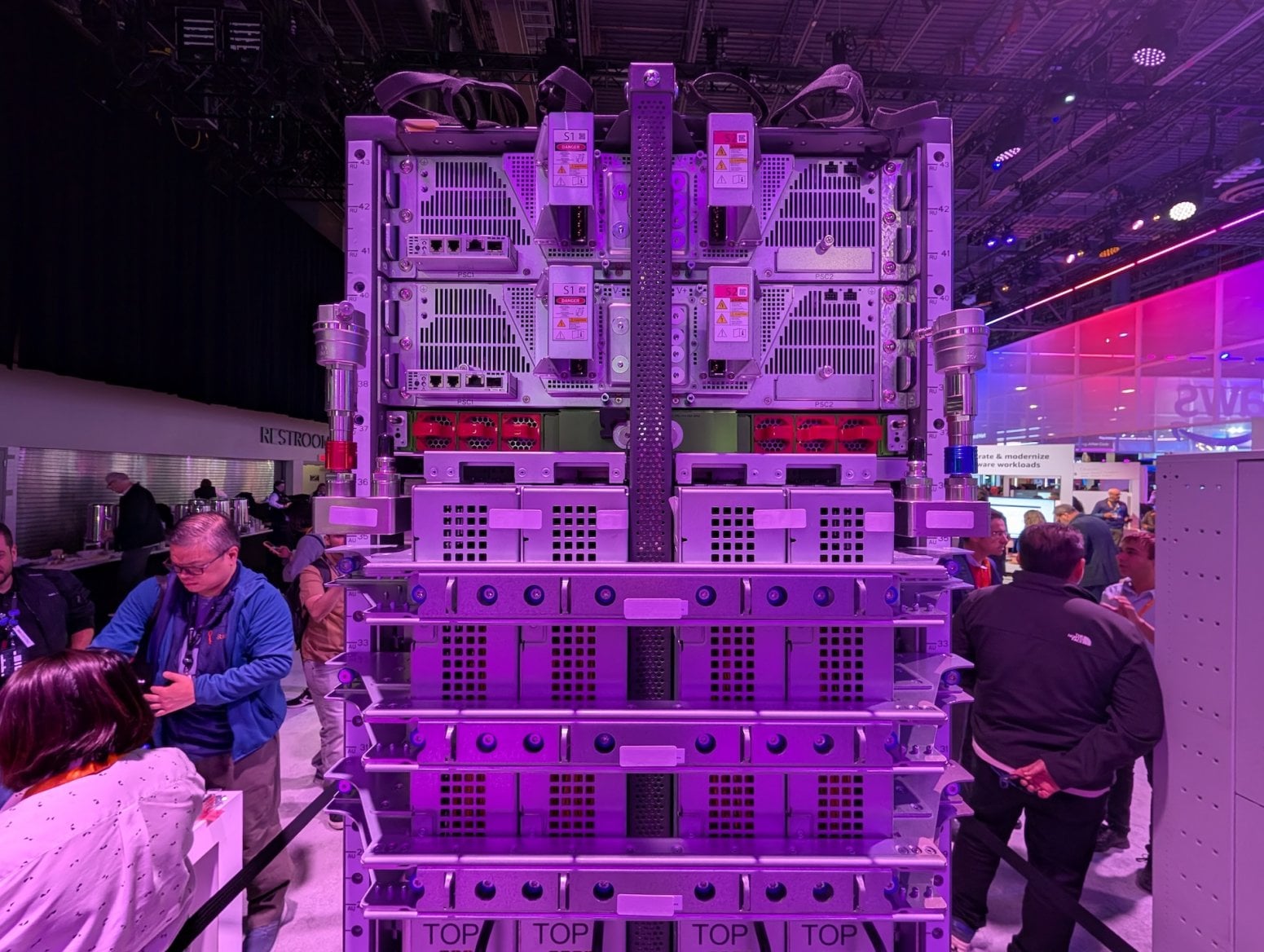

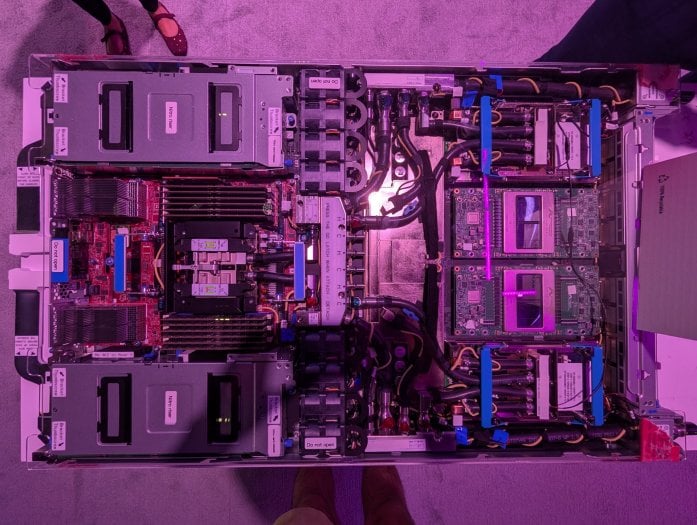

Trainium3 obsahuje 144 GB paměti HBM3e, což je velmi srovnatelné s Nvidií. Propustnost činí 4,9 TB/s. Čip umí pracovat s datovými typy FP32, BF16, MXFP8 a MXFP4, přičemž v MXFP8 to dělá výkon 2,25 petaflops. Tyto čipy se skládají do serverů. Takzvané Trn3 UltraServers mají až 144 čipů Trainium3, 20,7 TB HBM3e, propustnost 706 TB/s a přepínače NeuronSwitch-v1. Agregovaný výkon dosahuje na až 362 petaflops (FP8).

UltraServery se pak zapojují do clusterů (datových center) s názvem UltraCluster, lze spojit až milion čipů. Detailní analýza je na SemiAnalysis. Naše Galerie obsahující UltraServery, Trainium 3 nebo Graviton naleznete zde a zde.

AWS zároveň jako jeden z prvních mimo Nvidii začíná používat technologii NVLink umožňující spojovat více AI čipů do jednoho systému. Jde o vynález Nvidie, která si ho dlouho nechávala pro sebe, ale v květnu ho skrze NVLink Fusion otevřela i pro další zájemce.

A takto vypadá Cerebras WSE-3, největší čip na světě, který se rovněž používá pro umělou inteligenci: